Realitätsnahe KI-Videos: Sora von OpenAI verwandelt Text in lebendige Filme

Jeder kann Videos jetzt selbst drehen, ohne dafür eine Kamera in die Hand nehmen zu müssen. Man muss nur seine Gedanken dazu niederschreiben. Text-zu-Video-Generatoren wie Sora übernehmen alles Weitere und produzieren das Video direkt in der Cloud.

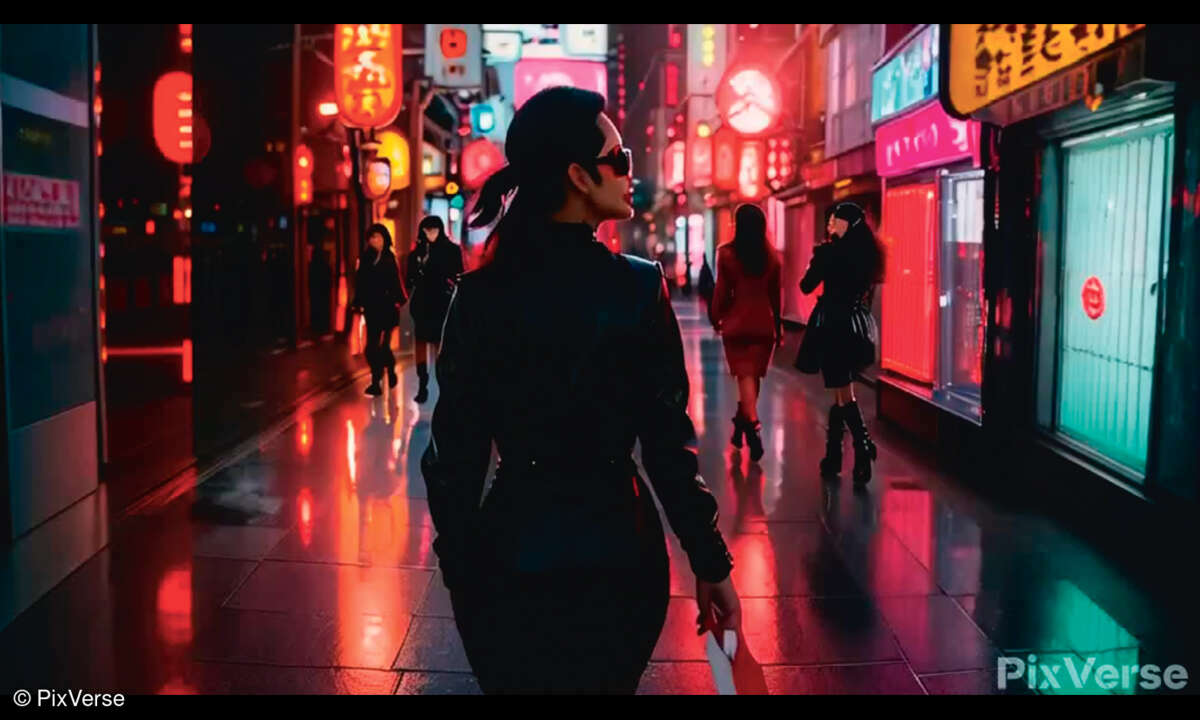

Eine Frau spaziert in der Nacht durch eine Großstadt. Sie trägt eine schwarze Lederjacke, ein langes rotes Kleid und schwarze Stiefel. Die regennasse Straße, auf der die Protagonistin im Video flaniert, spiegelt die Neonreklamen der umliegenden Gebäude wider. Was nach einer Filmszene aussieht, i...

Eine Frau spaziert in der Nacht durch eine Großstadt. Sie trägt eine schwarze Lederjacke, ein langes rotes Kleid und schwarze Stiefel. Die regennasse Straße, auf der die Protagonistin im Video flaniert, spiegelt die Neonreklamen der umliegenden Gebäude wider. Was nach einer Filmszene aussieht, ist komplett am Computer entstanden. Das Besondere daran: Erstellt wurde diese Filmsequenz vom Text-zu-Video-Generator Sora (openai.com/sora).

Für diesen Videodreh war lediglich eine kurze Texteingabe erforderlich, die die Szene beschreibt. Benötigt wurden somit weder Kamera-Equipment oder Kenntnisse im Videoschnitt noch sonderlich viel Zeit. Legt man nach der Texteingabe eine kurze Kaffeepause ein, sind die bis zu einer Minute langen KI-Filme laut Sora-Entwickler OpenAI schon fertig gedreht, wenn die Tasse leergetrunken ist.

Täuschend echte Videos

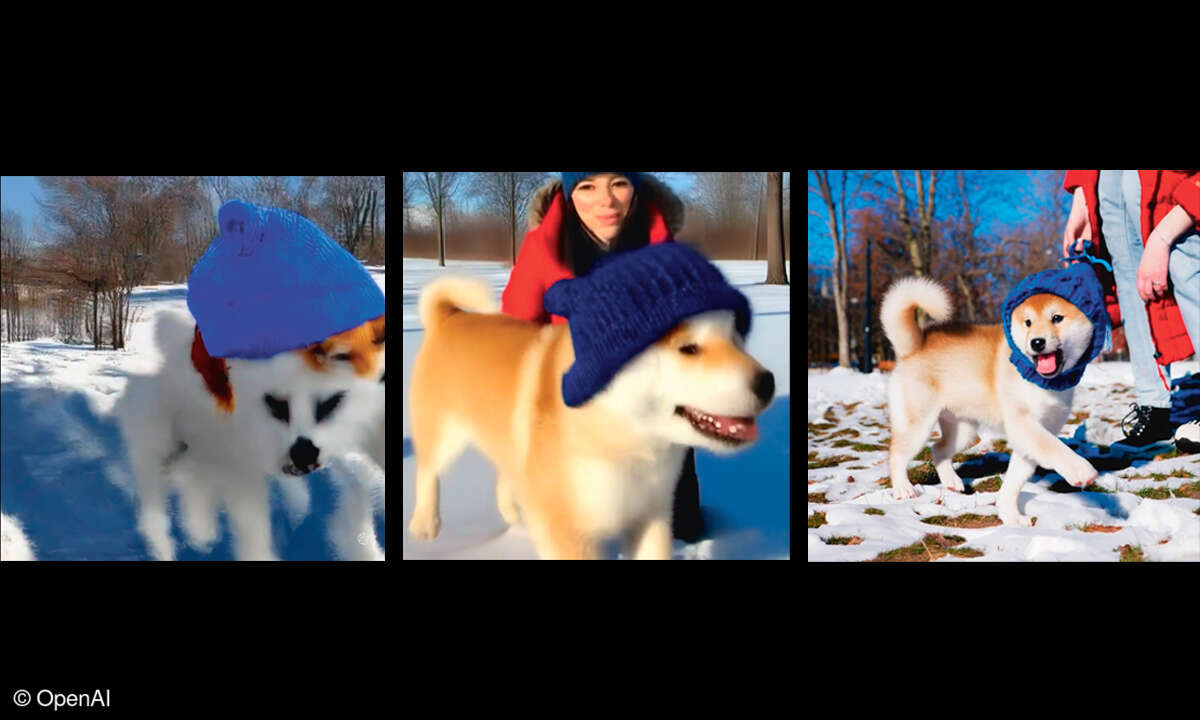

Auf der Sora-Webseite finden sich weitere Beispielvideos, bei denen die künstliche Intelligenz Regie geführt hat. Zu sehen sind darin unter anderem im Schnee spielende Hundewelpen, eine Geburtstagsfeier samt Torte und brennenden Kerzen, eine kalifornische Kleinstadt während des Goldrauschs um das Jahr 1850, zwei Piratenschiffe, die sich eine Seeschlacht in einer Kaffeetasse liefern, und einen Kameraschwenk durch eine Kunstgalerie, an deren Wänden viele großformatige Gemälde hängen.

Die KI-Filme wirken erstaunlich fotorealistisch und stimmig. Bei Hauttönen, Schattenwürfen und Materialanmutung können sie genauso überzeugen wie bei Bewegungen und Lichtreflexionen. OpenAI zufolge wurden sie nicht nachbearbeitet, sondern sind das direkte Resultat der Texteingabe.

Den Titel des ersten Text-zu-Video-Generators kann Sora zwar nicht für sich beanspruchen, denn andere wie Pika oder Runway Gen-2 waren schon früher am Start. Hinsichtlich Bildqualität schlägt das KI-Tool die Konkurrenz aber deutlich. Seine Talente beschränken sich nicht auf die Interpretation von Wörtern und Sätzen.

Sora kann auch ein Bild in ein Video verwandeln, bestehende Videos vorwärts und rückwärts in der Zeitleiste verlängern, zwei Videos zu einem zusammenfassen oder Bilder und animierte Grafiken erstellen. Die von der KI kreierten Videos sind maximal eine Minute lang, haben eine Auflösung von bis zu 1920 x 1080 Pixeln im Quer- respektive von 1080 x 1920 Pixeln im Hochformat.

Sora macht noch Anfängerfehler

Benannt wurde Sora nach dem japanischen Wort für Himmel. Damit deutet OpenAI selbstbewusst an, dass es für die Fähigkeiten seines KI-Tools kein Limit nach oben gibt. Perfekt ist die erste Version von Sora allerdings nicht, wie seine Entwickler feststellen. Einmal, weil die Videos keinen Ton haben. Zum anderen bereitet es Sora mitunter Schwierigkeiten, die Physik komplexerer Szenen und den Zusammenhang zwischen Ursache und Wirkung zu verstehen.

Demonstriert werden solche KI-Halluzinationen auf der Sora-Webseite anhand diverser Outtakes. Darunter findet sich zum Beispiel ein Video, in dem ein Jogger auf einem Laufband läuft – allerdings in umgekehrter Richtung. Wer genau hinsieht, erkennt in den KI-Filmen weitere kleine Inkonsistenzen, zum Beispiel unnatürlich wirkende Handbewegungen oder ein etwas zu steifer Gang von Personen, so als würde ein Alien im Menschenkostüm stecken. Weiß man jedoch nicht, dass es sich bei den nachgebildeten realen Szenen um KI-Clips handelt, erscheint auf den ersten Blick alles echt.

Vor gerade mal einem Jahr waren KI-generierte Videos noch eindeutig als solche zu erkennen. Prominentes Beispiel ist ein viraler Clip, in dem der Schauspieler Will Smith Spaghetti isst – eine unterhaltsame, allerdings auch etwas gruselige Mischung aus comic-artiger Animation und Morphing-Effekten.

Nur ein Jahr später zeigt uns Sora, dass sich KI-Videos qualitativ um Längen verbessert haben. Die Minifilme sehen so realistisch aus, dass sie sich sogar für den professionellen Einsatz eignen. Denkbar sind zum Beispiel Anwendungsszenarien wie Werbefilme, Präsentationen, die Animation von Prototypen oder simulierte Flüge mit einer Kameradrohne. Regisseure oder Schauspieler kann Sora aber nicht ersetzen.

Videos zu erstellen, die nicht nur für die Dauer von einer Minute kohärent sind, sondern eine Stunde und länger eine aus vielen Szenen bestehende und dabei logische, zusammenhängende und idealerweise auch spannende Handlung erzählen, ist mit den aktuellen KI-Modellen nicht machbar. Sora und die Mitbewerber dürften künftig aber noch deutlich mehr können als heute.

Unter der Haube: ein Diffusions-Transformator

Sora arbeitet mit einem Diffusionstransformator-Modell, das ist eine Kombination aus Transformer-Architektur und Diffusionsmodell-Technologie. Beim Diffusor-Part geht das Tool ähnlich vor wie Text-zu-Bild-Generatoren, zu denen neben DALL-E zum Beispiel auch Stable Diffusion und Midjourney gehören.

Jedes einzelne Frame des Videos besteht anfangs nur aus groben Bild-Bruchstücken. Diese wandelt Sora dann mittels maschinellem Lernen so lange um, bis das Gesamtbild der Textbeschreibung der Filmszene entspricht. Weil dabei mehrere Frames gleichzeitig berechnet werden können, verändern sich Objekte nicht, wenn sie teilweise oder vollständig aus dem Bild verschwinden.

Das Diffusionsmodell verknüpft Sora mit einer Transformer-Architektur, wie sie das KI-Sprachmodell GPT nutzt. Dafür werden die Bilder in kleinere Einheiten unterteilt, die Patches genannt werden. Sie lassen sich am besten mit den Tokens vergleichen, also den digitalen Einheiten, mit denen Sprachmodelle Text verarbeiten. Während bei Sora die Transformer-Architektur für die Organisation der Patches und Frames zuständig ist, erstellt das Diffusionsmodell den Inhalt für jeden Patch.

Alternativen zu Sora

Selbst ausprobieren kann man Sora nicht, da es sich derzeit noch in der Testphase befindet. Bis die OpenAI-Software der Öffentlichkeit zugänglich gemacht ist, kann man andere Text-zu-Video-Generatoren nutzen, von denen wir hier eine Auswahl vorstellen.

Runway Gen-2 ist einer der bekanntesten Text-zu-Video-Generatoren und derzeit eine der besten öffentlich verfügbaren Alternative zu Sora. In der Gratis-Version erstellt das KI-Tool bis zu vier Sekunden lange Videos, die im Standardformat 16:9 eine Auflösung von 1408 × 768 Pixen haben. Die Standbilder sehen sehr gut aus, die Videos sind aber nicht allzu realistisch. Animationen wirken oft unnatürlich, und Gesichtszüge von Personen verändern sich teilweise stark. Die Texteingabe erfolgt standardmäßig in Englisch.

Runway Gen-2 versteht auch Deutsch, interpretiert bei unseren Tests aber Eingaben falsch. Videos sind binnen Minuten erstellt und werden auch zum Download angeboten. Alternativ lassen sich Filme aus einer Bildvorlage erstellen.

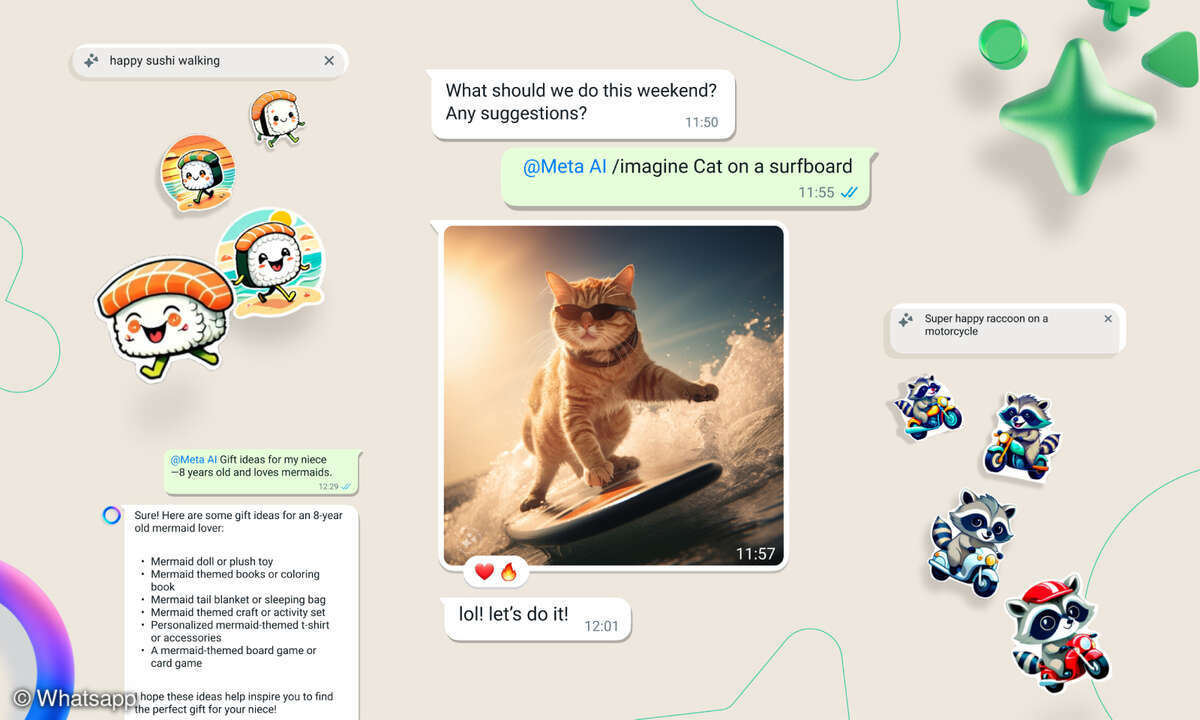

Die Text-zu-Video-Apps Genmo, Haiper, Kaiber, Moonvalley, Pika und PixVerse bieten eine ähnliche Funktionalität wie Runway Gen-2, schneiden bei der Bildqualität aber etwas schlechter ab. Dafür kann man zum Beispiel bei Kaiber ein Musikstück hochladen und das Video in dessen Takt schneiden lassen, während Pika optional Soundeffekte in die Videos integriert, was jedoch einen Abo-Tarif voraussetzt.

PixVerse bietet als Extra einen Discord-Server an, der Videos per /create-Kommando erstellt. Bei Moonvalley ist Discord sogar Pflicht, denn die Videoerstellung gelingt nur über einen Chatbot. Einen großzügigen Gratis-Tarif bietet Genmo an, täglich kann man hier bis zu 100 Videos erstellen. Bei Haiper gibt es aktuell gar kein Limit bei der Anzahl der Videos.

Colossyan, Elai und Vidnoz schlagen in eine etwas andere Kerbe: Sie spezialisieren sich auf Videos für Werbe- und Schulungszwecke. Mit den KI-Tools lassen sich KI-Avatare generieren, die einen eingegebenen Text lippensynchron sprechen. Zur Auswahl stehen jeweils viele unterschiedliche Sprechertypen und Sprachen, darunter auch Deutsch.

InVideo und Pictory sind für Content Creator interessant, da sie Texte, Bilder, Videos und Musikstücke zu einem Video zusammenfügen, ohne dabei Kenntnisse bei der Videoproduktion vorauszusetzen.

So will openAI den Missbrauch seines KI-Tools verhindern

Sora befindet sich derzeit noch in der Testphase. Die nutzt Entwickler OpenAI dafür, um Sicherheitsmaßnahmen in sein KI-Tool einzubauen, die das Risiko des Missbrauchs minimieren sollen.

Leistungsfähige Text-zu-Video-Generatoren wie OpenAI Sora und Google Lumiere werfen viele Fragen zur Sicherheit und Ethik auf. Verläuft die Entwicklung der KI-Tools ähnlich rasant wie bisher, dürfte es künftig noch viel schwieriger werden, im Internet Echtes von Falschem zu unterscheiden.

Denkbar wären zum Beispiel täuschend realistisch aussehende Videos, in denen Personen etwas tun und sagen, was sie tatsächlich aber nie getan oder gesagt haben. Solche Deepfakes verletzen nicht nur das Persönlichkeitsrecht eines Menschen, da sie massiv in seine Freiheits- und Lebensbereiche eingreifen. Gefährlich wird es insbesondere dann, wenn die Fake-Videos dazu missbraucht werden, um politische Prozesse oder die öffentliche Meinung zu beeinflussen.

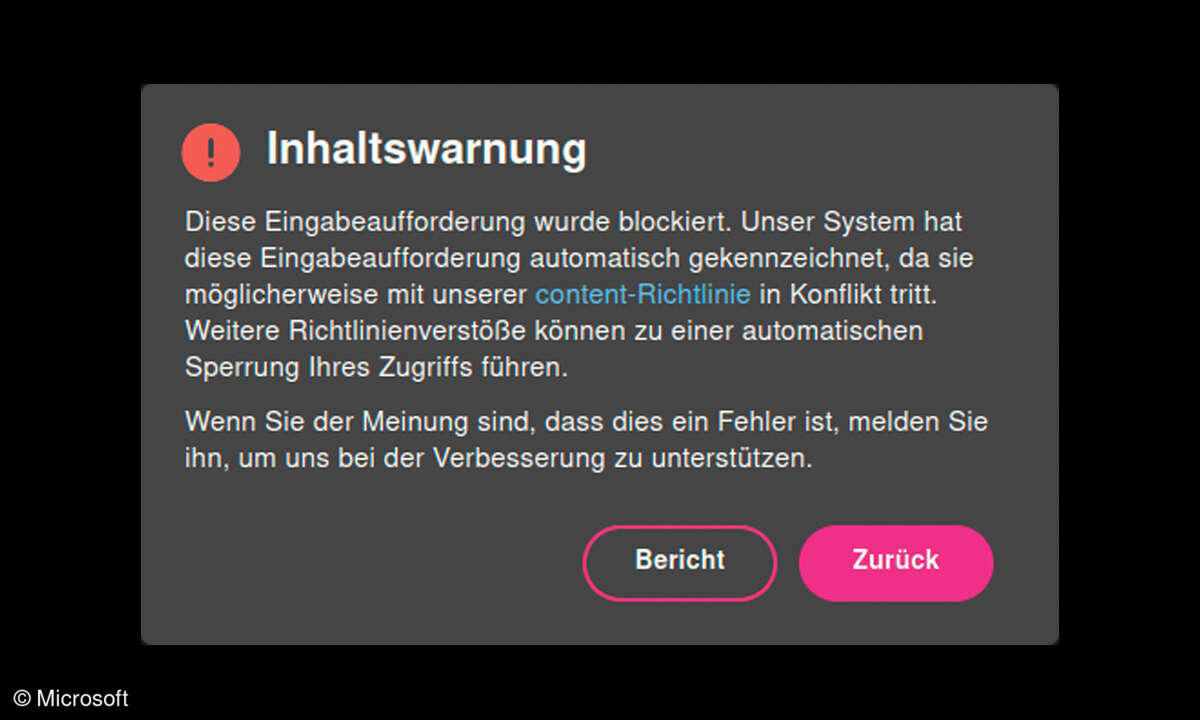

Eingabefilter und Metadaten

Um zu verhindern, dass Sora fragwürdige Inhalte und Falschinformationen produziert, sollen mehrere Sicherheitsebenen greifen. Einige davon übernimmt das KI-Tool direkt vom Text-zu-Bild-Generator DALL-E 3, der ebenfalls von OpenAI entwickelt wurde. So wird es nicht möglich sein, Videos aus Bildern zu generieren, die Politiker oder prominente Personen zeigen.

Auch ein Eingabefilter dürfte implementiert werden, um sexuelle Inhalte oder Darstellungen von Gewalt auszuschließen. Zudem sollen Erkennungsmerkmale wie C2PA-Metadaten die Videos als KI-kreiert kenntlich machen. In den Sora-Beispielvideos signalisiert das auch ein rechts unten eingeblendetes Wasserzeichen.

Google als Hauptkonkurrent von Sora

Googles Text-zu-Video-Generator galt einen Monat lang als neuer Branchenstandard – bis Sora vorgestellt wurde. Dennoch erzeugt auch Googles KI-Modell eindrucksvolle Videos, und es wird stetig weiterentwickelt.

Im Rennen um den besten Text-zu-Video-Generator ist Google mit Lumiere (lumiere-video.github.io) momentan der Hauptkonkurrent von OpenAI Sora.

Bis zu fünf Sekunden lange Videos

Hinsichtlich ihrer Fähigkeiten ähneln sich Lumiere und Sora stark. Das aus dem Google-Vorgängerprojekt VideoPoet entstandene Lumiere kann Videos anhand von Texteingaben erstellen, bestehende Videos bearbeiten sowie Bildvorlagen digital zum Leben erwecken. Dabei lassen sich die Animationen beliebig im Stil anpassen.

Lumiere-Videos haben derzeit eine Länge von fünf Sekunden und bestehen aus 80 Frames, wobei 16 Frames pro Sekunde dargestellt werden können. Google Lumiere können Anwender noch nicht selbst ausprobieren, da sich das KI-Tool genauso wie Sora noch in der Entwicklungsphase befindet.

Auf der Lumiere-Webseite hat Google dafür schon zahlreiche Beispielvideos vorgestellt. Zur Bildgenerierung bedient sich Lumiere genauso wie Sora eines Diffusionsmodells, das Bilddetails mittels maschinellem Lernen aus anfangs stark verrauschten Frames herausarbeitet.

Für die Animation der Einzelbilder verwendet Google ein spezielles Verfahren, das auf der sogenannten Raum-Zeit-U-Netz-Architektur basiert (Space-Time U-Net oder STUNet). Anstatt wie viele andere Text-zu-Video-Generatoren Keyframes zum Rendern zu nutzen, generiert Lumiere mit Hilfe von STUNet das komplette Video in einem Durchgang, um die Bewegungsabläufe möglichst realistisch aussehen zu lassen.

FAQ - Häufig gestellte Fragen zu Sora und Text-zu-Video-Generatoren

1. Was ist Sora? Sora ist ein Text-zu-Video-Generator, der von OpenAI entwickelt wurde. Er kann aus kurzen Texteingaben realistisch wirkende Videosequenzen erstellen, ohne dass Kamera-Equipment oder Kenntnisse im Videoschnitt erforderlich sind.

2. Wie funktioniert Sora? Sora nutzt ein Diffusions-Transformator-Modell, das eine Kombination aus Transformer-Architektur und Diffusionsmodell-Technologie ist. Durch maschinelles Lernen wandelt Sora Textbeschreibungen in Videosequenzen um, indem es grobe Bild-Bruchstücke schrittweise verfeinert.

3. Welche Arten von Videos kann Sora erstellen? Sora kann eine Vielzahl von Szenen und Situationen visualisieren, von alltäglichen Szenarien wie einer nächtlichen Stadtszene bis hin zu fantastischen Szenarien wie zwei Piratenschiffe, die sich eine Seeschlacht in einer Kaffeetasse liefern

4. Wie lange dauert es, bis Sora ein Video erstellt? Sora kann Videos von bis zu einer Minute Länge innerhalb kurzer Zeit generieren. Die Zeit hängt von der Komplexität der Szene und der Länge des Textes ab, aber laut Angaben von OpenAI kann ein Video bereits fertig sein, wenn man eine kurze Kaffeepause einlegt.

5. Welche sind die Hauptmerkmale von Sora im Vergleich zu anderen Text-zu-Video-Generatoren? Sora zeichnet sich durch seine hohe Bildqualität und Vielseitigkeit aus. Es kann nicht nur Videos aus Text erstellen, sondern auch bestehende Videos bearbeiten, Bilder in Videos umwandeln und verschiedene Szenen zusammenführen.

6. Gibt es Einschränkungen oder Probleme bei der Verwendung von Sora? Obwohl Sora beeindruckende Ergebnisse liefert, hat es noch einige Anfängerfehler und Inkonsistenzen. Zum Beispiel fehlt den generierten Videos oft der Ton, und in komplexen Szenen kann es zu physikalischen Ungenauigkeiten kommen.

7. Wann wird Sora der Öffentlichkeit zugänglich gemacht? Sora befindet sich derzeit noch in der Testphase, und es ist noch nicht bekannt, wann es der breiten Öffentlichkeit zugänglich gemacht wird. Interessierte können jedoch bereits andere Text-zu-Video-Generatoren ausprobieren, die bereits verfügbar sind.

8. Welche Alternativen gibt es zu Sora? Es gibt mehrere Alternativen zu Sora, darunter Runway Gen-2, Genmo, Haiper, Kaiber, Moonvalley, Pika, PixVerse, Colossyan, Elai, Vidnoz, InVideo und Pictory. Jede dieser Plattformen bietet ähnliche Funktionen, aber mit unterschiedlicher Bildqualität und zusätzlichen Features.

Eine Auswahl an Alternativen zu Sora:

- Colossyan

www.colossyan.com

Videolänge bis 30 Min.

Videopräsentationen mit KI-Avataren - Elai

elai.io

Videolänge bis 1 Min.

Videopräsentationen mit KI-Avataren - Genmo

www.genmo.ai

Videolänge bis 6 Sek.

großzügiges tägliches Limit für die Anzahl der Videos - Haiper

www.haiper.ai

Videolänge bis 4 Sek.

derzeit kein Limit bei der Anzahl der Videos - InVideo

invideo.io

Videolänge bis 10 Min.

erstellt multimediale Videos für Blogposts und Social Media - Kaiber

kaiber.ai

Videolänge bis 6 Sek.

Video-Generierung im Rhythmus von Musikstücken - Moonvalley

moonvalley.ai

Videolänge bis 5 Sek.

Video-Generierung über Discord-Chatbot

- Pictory

pictory.ai

Videolänge bis 10 Min.

erstellt multimediale Videos für Blogposts und Social Media - Pika

pika.art

Videolänge bis 3 Sek.

Video-Generierung mit optionalen Soundeffekten - PixVerse

pixverse.ai

Videolänge bis 4 Sek.

Video-Generierung optional auch über Discord-Chatbot - RunwayGen-2

research.runwayml.com/gen2

Videolänge bis 4 Sek. eine der derzeit besten Alternativen zu OpenAI Sora - Vidnoz

de.vidnoz.com

Videolänge bis 3 Min.

Videopräsentationen mit KI-Avataren; Klonen der eigenen Stimme